ChatGPT bez wątpienia okazał się rewolucją, która prawdopodobnie na zawsze zmieniła to jak dzisiaj wyszukujemy informacje i rozwiązujemy problemy. Apple nie zamierza odpuścić tej rewolucji i szykuje własnego asystenta ze wsparciem generatywnej sztucznej inteligencji.

Nikt się chyba nie spodziewał jakie reperkusje będzie miała premiera ChataGPT, od której minie za kilka dni dokładnie 2 lata. NVIDIA awansowała do awangardy najdroższych spółek świata, a kolejne firmy prześcigają się w prezentacji coraz bardziej zaawansowanych modeli. OpenAI nadal zdaje się być liderem tego wyścigu, ale po piętach depcze mu Google ze swoimi modelem Gemini, a także Anthropic z modelem Claude AI. Nieco w tyle zdaje się zostawać Apple, ale wygląda, że nie za długo.

Polecamy na Geekweek: Rewolucja w medycynie. Sztuczna inteligencja pomoże nam w leczeniu?

LLM Siri w przygotowaniu

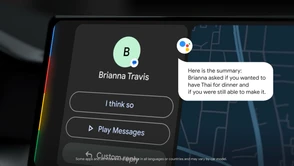

Niezawodny Mark Gurman z Bloomberga donosi, że Apple podjęło decyzję o znacznym rozbudowaniu możliwości asystenta Siri. Gigant z Cupertino co prawda oferuje już swoją usługę Apple Intelligence, która bazuje na generatywnej sztucznej inteligencji, ale zamierza pójść jeszcze o krok dalej. Siri świetnie sprawdza się w prostych zadaniach, ale biorąc pod uwagę rozwój Gemini od Google czy Alexy od Amazona, nie może sobie pozwolić na to aby zostać w tyle. Dlatego Apple rozpoczęło pracę nad nową wersją asystenta, która obecnie jest określana jako LLM Siri (Large Language Model Siri). Będzie to asystent, z którym będzie można porozmawiać w języku naturalnym, poprosić o poszukanie informacji, ale nadal jednocześnie otworzyć bramę garażową czy zapalić światła w salonie.

Asystent LLM Siri ma być zaprezentowany na wiosnę 2026 roku i pojawi się zarówno w smartfonach Apple jak i w głośnikach. Więcej szczegółów powinniśmy poznać w przyszłym roku, prawdopodobnie podczas konferencji WWDC. Wygląda też na to, że Apple zamierza samodzielnie stworzyć swój model i nie będzie korzystać z pomocy innych firm. Apple Intelligence w dużej mierze bazuje na rozwiązaniach OpenAI. Przedstawiciele firmy od wielu lat podkreślają też swoje przywiązanie do prywatności, nie jest więc też wykluczone, że LLM Siri będzie niewielkim modelem, z którego można korzystać lokalnie, przy pomocy NPU wbudowanego w procesor. Jedno jest pewne, jeśli kolejny gigant o głębokich kieszeniach dołącza do wyścigu, to boom na procesory do szkolenia modeli AI prawdopodobnie jeszcze nie osiągnął swojego szczytu.

Hej, jesteśmy na Google News - Obserwuj to, co ważne w techu