Gdy pojawiły się przecieki o trybie Cinematic Mode, zmieniło to moje oczekiwania wobec nadchodzących iPhonów 13. Na ich debiut czekałem tylko po to, żeby obniżyły ceny 12 mini. Przez pytanie o to, jak Apple ogarnie tak trudny temat, 13-ka stała się interesująca sama w sobie.

Tryb portretowy w wysokiej jakości smartfonach przez ostatnie lata mocno dojrzał i stał się naprawdę przydatną opcją w będących zawsze pod ręką telefonach. Jednak jego zastosowanie w fotografii jest o niebo łatwiejsze niż w filmie, w którym mamy nie tylko 24 - 30 zdjęć na sekundę w normalnych trybach, ale też większość kadru jest w ruchu. To powoduje konieczność posiadania znacznie większej ilości punktów odniesienia i dużo większych mocy obliczeniowych.

Dlaczego to niełatwe?

Kiedy ponad rok temu uczestniczyłem w prezentacji nowych sensorów foto/video Sony z wbudowanymi układami AI, zadałem pytanie inżynierowi tej firmy, czy jest szansa na tryb portretowy w wideo w zfokusowanych przecież na kręcenie video Xperiach. Odpowiedź była dość wymijająca i podkreślono w niej właśnie skalę trudności związaną z takim procesem. Apple najwyraźniej nie przestraszyło się i jako pierwsi dostarczyli to rozwiązanie na rynek.

Pokaz tej funkcji na prezentacji iPhonów wyglądał zaskakująco dobrze, ale wiadomo, że ekipa produkująca filmy marketingowe ma czas i może powtarzać ujęcia aż do uzyskania odpowiedniego rezultatu. Dodajmy, że za te filmy odpowiadali najwyższej klasy profesjonaliści z Hollywood, którzy potrafili ustawić lokację, oświetlić ja i dobrać kadry tak, aby wyciągnąć z tego systemu maksymalne efekty.

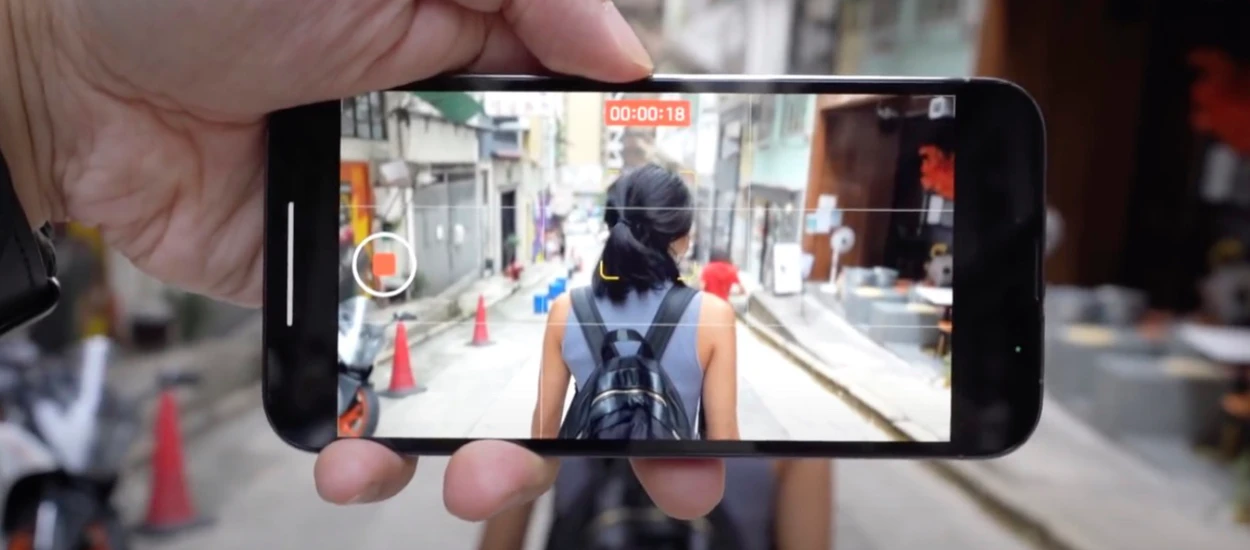

Jak jednak ten system sprawdzi się w rękach zwykłych ludzi i naturalnych lokacjach? Pierwsze filmy zaczynają się już pojawiać na YouTube i muszę przyznać, że jestem pod sporym wrażeniem. Nie chodzi o to, że błędy nie występują, jest ich sporo, ale biorąc pod uwagę, że to pierwsza implementacja, że AI będzie dalej trenowane, to jest zaskakująco dobrze. Oczywiście im mocniejszy efekt chcemy uzyskać, tym z większą liczbą błędów musimy się liczyć.

Co działa, a co nie działa

To, co na pierwszy rzut oka widać, to że najlepiej wychodzą ujęcia, w których postacie są w centrum kadru i idą w stronę, lub odchodzą od kamery. Jeśli ustawiamy kamerę pod kątem do postaci, a w kadrze pojawi się sporo drobnych elementów, zaczynają wychodzić różne artefakty, najczęściej w postaci „duszków” na krawędziach przedmiotów. Podobnie jest gdy zbyt szybko okrążymy „ofiarę”. Nie znaczy to, że takich ujęć nie da się nakręcić, da się, trzeba tylko dobrze przemyśleć, co z kadru usunąć.

Tradycyjnie problemy sprawiają włosy i miejsca o zbyt małym kontraście pomiędzy tłem a postacią (np. krawędź szarych legginsów na tle ulicy). Warto w tym miejscu dodać, że część ujęć można uratować w postprodukcji przeostrzając w inne miejsce, osłabiając, lub w ogóle wyłączając ten efekt. Niewielkie różnice pomiędzy tymi trybami w 13 i 13 Pro wskazują, że w tym drugim smartfonie procesu nie wspomaga LIDAR, co jest trochę dziwne. Zaskakująco dobrze działają za to tryby automatycznej zmiany tematu „ostrzenia”, choć wiadomo, że przy większej ilości osób w kadrze, system kompletnie się pogubi.

W recenzji Joanny Stern z WSJ widać, że AI nie radzi sobie zbyt dobrze w dziwacznym oświetleniu, które spreparowano na potrzeby kręceniu tego „teledysku”. Problemy widać też z mocno kręconymi włosami modelki na tle żywopłotu, tu podejrzewam, że wzorzec obu tych elementów w skali szarości jest zbyt podobny, dając efekt taki, jak przy obiektach zbyt mało skontrastowanych.

Dieter Bohn z The Verge zauważył z kolei, że tryb Cinematic Mode przestaje działać w słabym oświetleniu. Na ich filmie widać, jak efekt gubi się i powraca w różnych momentach. Przeczy to marketingowemu przekazowi z filmów Apple, kręconych w dużej części w niskim kluczu. Obstawiam, że w tej kwestii bardzo wiele zależy od samego rozkładu oświetlenia. Profesjonalna ekipa Apple odpowiednio oświetliła to co trzeba, a wyciemniła to co przeszkadza, w prawdziwym świecie trzeba będzie odpowiedniego miejsca metodą prób i błędów poszukać. Pozostaje też pytanie, czy zablokowanie ostrości na postaci jest w stanie tę sytuację poprawić.

Cinematic Mode 30 fps...

Zaskakującą decyzją „in minus” jest zastosowanie tego trybu tylko do 1080p przy 30 kl/s. Przy czym nie chodzi mi o rozdzielczość, konieczność ograniczenia ilości danych do analizy jak najbardziej rozumiem, ale o brak filmowej opcji 24 kl/s w trybie Cinema to jakiś żart. Ten klatkarz nie tylko powinien być łatwiejszy dla AI, ale sam charakter takiego obrazu jest bardziej filmowy.

Niemniej, nawet tak niedopracowane Cinema Mode jest dla mnie argumentem za kupnem iPhone 13 mini (choć nie tak dużym, jak lepsza bateria), zamiast 12-ki. Część rzeczy zostanie na pewno dopracowana w kolejnych aktualizacjach, inne „odblokują” zapewne twórcy bardziej zaawansowanych programów do kręcenia filmów. Już teraz widać, że niedługo wielu twórców zacznie wyciskać z tego systemu, co tylko się da.

Podoba mi się taka ewolucja, cały czas czekam też, aż któryś z producentów dołoży elektroniczny filtr ND o płynnej regulacji lub rozwiąże tę kwestię przy pomocy algorytmów AI (symulator szybkości migawki). Smartfony oczywiście nie zastąpią profesjonalnych narzędzi do kręcenia video, ale ludziom nietrawiącym „elektronicznego” obrazu mogą niedługo pozwolić na robienie filmów rodzinnych na znacznie wyższym niż kiedyś poziomie.

Hej, jesteśmy na Google News - Obserwuj to, co ważne w techu