Sprawa wygląda tak, że chcemy mieć androidy i muszą być takie jak w filmie Blade Runner, bo inaczej nie ma sensu się za to zabierać. Antropomorficzne roboty, których nie da się odróżnić od ludzi to ciężki temat - nie mam tu na myśli moralnych wątpliwości, lecz problemy natury technicznej…

Facebook szkoli AI w naturalnym imitowaniu ludzkiej twarzy przy pomocy Skype

Jak przełamać dolinę niesamowitości?

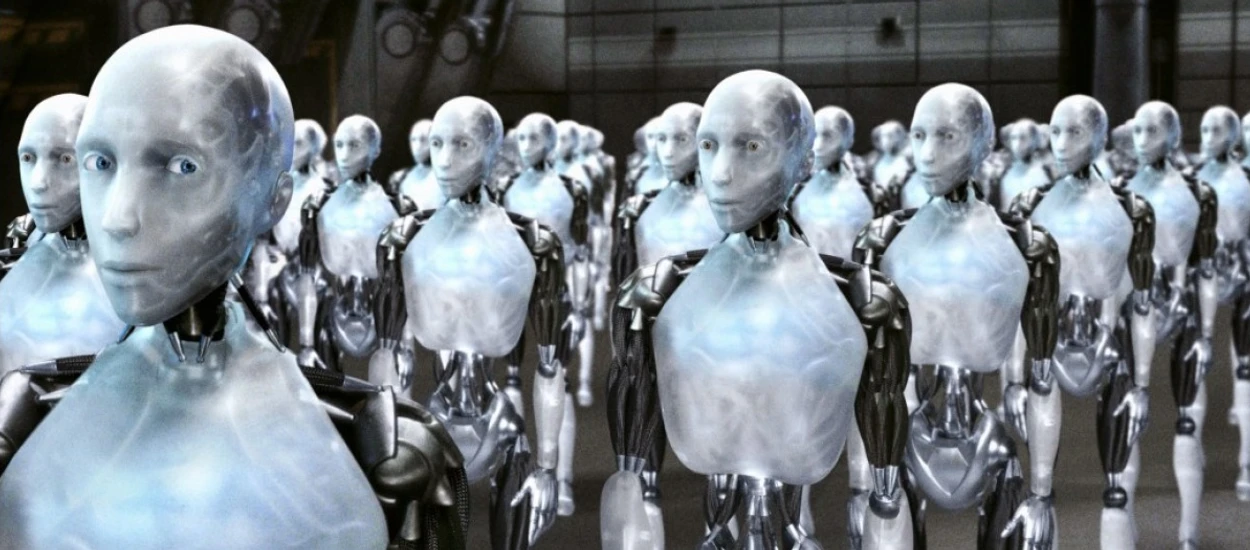

Żeby stworzyć robota, który będzie taki jak człowiek, trzeba umieć… tworzyć takie roboty. Aktualnie nie posiadamy tego typu możliwości i jedyne co nam z tego wychodzi to przerażające kreatury, które wpadają do tzw. doliny niesamowitości, czyli powodują u ludzi strach i dyskomfort. Na szczęście Facebook chce ocalić świat od tego nieprzyjemnego zjawiska! Dzięki pracy ludzi z FAIR (Facebook AI Research) tworzone są fundamenty, na których w końcu zostanie postawiony świat wypełniony androidami, prawie jak w filmie Blade Runner:

Przyszłość w której ludzkość w końcu nauczyła się wytwarzać roboty całkowicie imitujące swoich stwórców musi być niesamowita, prawda? Robot wyglądający i zachowujący się dokładnie tak samo jak człowiek, mógłby bez problemu przejąć niektóre z cięższych zadań i wyręczyć nas z konieczności ich wykonywania. W przyszłości androidy mogłyby być zsyłane na misje kolonizacyjne, po to aby uniknąć potencjalnych strat w ludziach. Brzmi jak dobre rozwiązanie.

Oto pierwszy trailer Blade Runner 2049. Jest fenomenalny.

Nad czym pracują ludzie z FAIR?

Algorytm AI, który odpowiada za kontrolę animacji twarzy jest szkolony do tego, żeby doskonale wywiązywać się ze swojego zadania. Co możemy uznać za stan rzeczy, w którym wspomniany bot osiąga swój cel? Sytuację, w której ludzki rozmówca uznaje, iż wspomniana animacja twarzy zachowuje się bardzo naturalnie i dostosowuje swoje ekspresje w taki sposób, że można odnieść wrażenie wyjątkowo naturalnego zachowania.

Nie myślimy o tym na co dzień, ale w momencie kiedy z kimś rozmawiamy, nasze podświadome zachowanie sprawia, że jesteśmy dobrym rozmówcą. Jest tak bo np. dajemy odczuć drugiej osobie, że jej słuchamy, a składają się na to drobne kiwnięcia głową, ruch ustami, mrugnięcia… Masa drobnostek, które ciężko tak po prostu sztucznie naśladować za pomocą robota czy animacji. Właśnie dlatego najlepiej będzie to wytrenować… W tym wypadku za materiał szkoleniowy posłużyły nagrania rozmów prowadzonych na Skype.

System nauczył się tak sterować animacją, że widząc swojego rozmówcę w czasie rzeczywistym dobierał idealne rekcje, dzięki którym człowiek odnosił pozytywne wrażenie. Chodzi o drobnostki typu: człowiek się zaśmiał, więc ja przechylę lekko głowę i delikatni otworzę usta. Tego typu komunikaty niewerbalne są równie ważne, co umiejętność sprawnego rozpoznawania mowy i udzielania odpowiedzi głosowych, dlatego specjaliści z FAIR postanowili poświęcić temu swój czas i zasoby.

Dobry początek

To tylko prosta animacja, więc trudno tu mówić o przekraczaniu granic wyznaczonych przez dolinę niesamowitości. Jednak w przyszłości algorytmy z podobnymi umiejętnościami, mogłyby pomóc robotom w sprawnym zarządzaniu reakcjami swojej… sztucznej twarzy podczas rozmowy z człowiekiem. Może nawet uda się przygotować szeroki pakiet różnych osobowości, które będą mogły być wyrażane dzięki sprawnie zrealizowanej komunikacji niewerbalnej? Miejmy nadzieję, że tak, bo inaczej nigdy nie doczekamy się ciekawych zawodów typu „łowca androidów”.

Bonus:

Trochę w temacie, a trochę „off topic”. Jeśli ktoś jeszcze nie widział, to polecam:

Hej, jesteśmy na Google News - Obserwuj to, co ważne w techu