Prawo Moore'a to określenie faktu, jaki opisał w 1965 roku Gordon Moore, jeden z założycieli Intela. Obserwacja ta dotyczyła faktu, że mniej więcej co roku liczba komponentów w układach scalonych podwajała się. 10 lat później ten sam człowiek wprowadził poprawkę i stwierdził, że przez najbliższą dekadę gęstość upakowania tranzystorów będzie podwajała się co 2 lata, tak samo też będzie rosła ich wydajność. Jak się okazuje zależność ta została zachowana do dzisiaj, stąd przyjęło się określenie "prawo Moore'a".

Podczas niedawnej konferencji GTC (GPU Technology Conference) w Chinach, Jen-Hsun Huang, jeden z założycieli NVIDII i wieloletni CEO tej firmy stwierdził, że to już niedługo GPU (procesory graficzne) zastąpią w wielu zastosowaniach zwykłe procesory (CPU). Nie jest to pewnie nic dziwnego, że szef największej firmy produkującej GPU na świecie stwierdza taki fakt. Warto jednak się nad tym dłużej zastanowić. Koniec prawa Moore'a ogłaszany był już wcześniej kilka razy, ale jak do tej pory za każdym razem Intel zdołał kolejnymi generacji swoich procesów technologicznych zachować tę zależność. Owszem, można odnotować pewne zahamowanie od mniej więcej 2012 roku, czyli od wymiaru 22 nm, ale mimo początkowych trudności udało się przejść na 14 nm. W przyszłym roku możemy spodziewać się układów 10 nm, a w perspektywie są jeszcze możliwości zejścia nawet do 5 nm. Problem tylko w tym, że nawet jeśli firmie Intel udaje się podwoić gęstość tranzystorów w CPU co 2 lata, to nie jest to adekwatne do wzrostu wydajności. Ten jest znacznie mniejszy.

Koniec prawa Moore'a to fakt

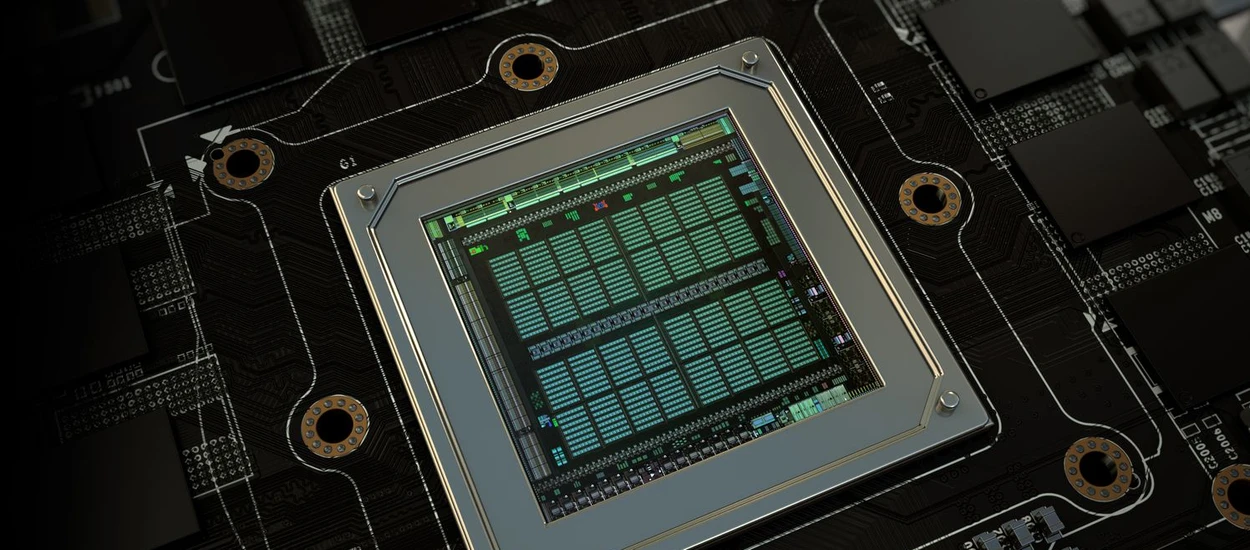

Według Jen-Hsun Huanga, nawet jeśli liczba tranzystorów w CPU wzrasta średnio o 50% rocznie, to ich wydajność w tym samym czasie rośnie o maksymalnie 10%. Problemem jest tutaj sama architektura, która powoli dochodzi do ściany. Jej możliwości się kończą, a wielowątkowość nawet najwydajniejszych procesorów CPU na rynku, nie może się równać z GPU. Te posiadają nawet kilkaset razy więcej jednostek obliczeniowych, które mogą pracować równolegle. Nie trudno też zauważyć, że od kilku lat zegary w procesorach praktycznie stoją w miejscu. To w połączeniu z brakiem przełomowych zmian w architekturze owocuje niewielkim wzrostem wydajności. Tym samym prędzej czy później prawo Moore'a przestanie działać, choć według ostatnich prognoz nie powinno to nastąpić przed 2025 rokiem.

GPU idealne dla AI i sieci neuronowych

CEO NVIDIA powiedział także, że to właśnie układy GPU lepiej nadają się do wszelkiego rodzaju zastosowań związanych z sztuczną inteligencją (AI) oraz sieciami neuronowymi. Te rozwiązania wykorzystywane są między innymi w samochodach Tesli. Nie bez powodu autopilota w Modelach S, X i 3 zasila właśnie układ NVIDIA (GPGPU). Procesor ten odpowiada za przetwarzanie danych z wielu czujników naraz i w połączeniu z oprogramowaniem pozwala na niemal autonomiczną jazdę. To jednak nie jedyne zastosowania, podczas konferencji w Chinach, NVIDIA oficjalnie ogłosiła, że jej rozwiązania do przetwarzania danych zastosowały właśnie największe firmy e-commerce w Państwie Środka. Mowa tutaj o takich gigantach jak Alibaba, Baidu, Tencent, JD.com i iFLYTEK. Nie jest to nic nadzwyczajnego, bo GPU w swoich serwerach wykorzystuje też Google. Co więcej według pana Huanga, technologia NVIDII jest nawet pięciokrotnie tańsza w porównaniu do tradycyjnych procesorów. Właśnie z tego powodu spodziewa się on, że w przyszłości coraz częściej GPU, będzie zastępowało CPU.

Nie martwcie się, CPU nigdzie się nie wybiera

Warto jednak zaznaczyć, że te wszystkie sprawy wspomniane powyżej dotyczą rynku profesjonalnego. CPU w naszych domowych komputerach, laptopach czy tabletach nigdzie się nie wybierają. Z założenia taka jednostka jest znacznie bardziej uniwersalna niż GPU i na ten moment trudno sobie wyobrazić, aby CPU miał zniknąć z PeCeta.

Hej, jesteśmy na Google News - Obserwuj to, co ważne w techu