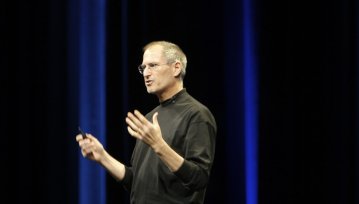

W tym miesiącu wypłynęła informacja, że Apple zamierza skanować zdjęcia w poszukiwaniu treści pedofilskich - wszystko dzięki mechanizmowi w iOS i iPadOS 15. Wysyłane do chmury iCloud grafiki będą sprawdzane przez algorytm wytrenowany w wyszukiwaniu obrzydliwych materiałów. Ostatnie doniesienia wskazują jednak, że Apple ten mechanizm wykorzystuje już od 2019 roku.

To odrobinę zmienia optykę na algorytm CSAM od Apple. Serwisy technologiczne oraz miejsca dyskusji jak na razie skupiały się wokół rychłego wprowadzenia mechanizmu do OS-ów giganta, a okazuje się że ten w iCloud już funkcjonuje od dłuższego czasu. Niekoniecznie mnie to zdziwiło: algorytm CSAM musiał zostać uprzednio wytrenowany i sprawdzony. Taki obrót sprawy jednak implikuje pewien problem: to, co wiemy o CSAM z poprzednich treści na jego temat jest już zapewne nieaktualne (bo bazujemy najprawdopodobniej na wcześniejszych iteracjach algorytmu). Już nie wspominając o tym, że nie wiedzieliśmy przecież o funkcjonowaniu algorytmu w iCloud. Użytkownicy ekosystemu Apple mogą poczuć się nieco oszukani.

Dlaczego? Bo w marketingowej retoryce Apple nader często przewija się prywatność. Dobre i skuteczne zabezpieczenia urządzeń oraz oprogramowania Cupertino wykorzystuje do budowania zaufania wśród swoich klientów. Można powiedzieć, że przecież algorytm CSAM wychwytujący treści pedofilskie nie jest czymś, co zagraża prywatności użytkowników. To po prostu maszyna, która znajduje obrzydliwe grafiki z dziećmi w roli głównej i flaguje konkretnych użytkowników / usuwa te materiały.

Skąd wiemy o działaniu mechanizmu CSAM od 2019 roku?

Źródłem jest Ben Lovejoy z serwisu 9to5mac, który w stworzonym przez siebie materiale wskazał na swoje ustalenia wewnątrz Apple:

Apple potwierdziło mi, że od 2019 roku skanuje wychodzące i przychodzące wiadomości iCloud Mail w poszukiwaniu załączników CSAM. Poczta elektroniczna nie jest szyfrowana, więc skanowanie załączników, gdy poczta przechodzi przez serwery Apple jest trywialnym zadaniem. Apple wskazało również, że wykonuje pewne ograniczone skanowanie innych danych, ale nie zdradziło mi, co to było, z wyjątkiem sugerowania, że było to na małą skalę. Powiedziano mi, że "inne dane" nie obejmują kopii zapasowych iCloud.

Na pierwszy rzut oka nie jest to nic złego, bo przecież walka z pedofilami to coś, co warto robić za wszelką cenę. Byłbym nawet za tym, by telefon wykrywający pedofila (o ile byłby w stu procentach pewny co do wskazań) wybuchał mu w rękach. Użytkownicy mogą jednak poczuć się nieco oszukani: bo tak na dobrą sprawę nie mają oni kontroli nad tym, w jaki realnie sposób algorytm CSAM działa. Są tacy ludzie, którzy zawsze zakładają że ich prywatność może być w takich sytuacjach zagrożona. Bo nic nie stoi na przeszkodzie, by podobny mechanizm na przykład skanował twarze, tworzył profile konkretnych osób lub oceniał np. status majątkowy posiadacza urządzenia na podstawie zdjęć w iCloud / plików na urządzeniu.

Jest jeszcze jeden problem. Princeton University stworzyło własny mechanizm CSAM i... nieco ich on zaskoczył

Działający prototyp działa bardzo podobnie do tego apple'owskiego. Otrzymuje on materiały do sprawdzenia i na podstawie tego, co wprowadzono do maszyny - ocenia, czy grafika wyczerpuje znamiona bycia tą niepożądaną. Na łamach Washington Post, Jonathan Mayer (asystent profesora ds. informatyki i spraw publicznych) oraz Anunay Kulshrestha (dyplomowana badaczka) wypowiedzieli się na temat swoich obserwacji w jego zakresie.

Nasz system może być łatwo ponownie wykorzystany do inwigilacji i cenzury. Projekt nie był ograniczony do konkretnej kategorii treści. (...) Zauważyliśmy też inne niedociągnięcia. Proces dopasowywania treści może dawać fałszywe wyniki pozytywne, a cyberprzestępcy mogą spróbować oszukac system, by to niewinni użytkownicy zostali wytypowani do kontroli oraz wezwania służb.

To już jest znacznie większy problem. Apple przed premierą iOS 15 będzie musiało się nieźle natrudzić aby obronić mechanizm CSAM, który ma znaleźć się w urządzeniach z iOS 15 oraz iPadOS 15. Niektórzy uważają, że gigant może zdecydować się nawet na wstrzymanie premiery algorytmu implementowanego w systemie, by w spokoju przeprowadzić kampanię wspierającą jego wizerunek i nieco uspokoić opinię publiczną. Część obserwatorów szczególnie zainteresowanych kwestiami prywatności, po publikacjach już nie tylko w Washington Post czy 9to5Mac - zaczęła wyrażać swoje niezadowolenie w dosyć głośny sposób. Opóźnienie wprowadzenia CSAM do telefonów oraz tabletów ma dać przestrzeń na wyprostowanie tej sytuacji.

O części algorytmów skanujących nasze pliki nie mamy pojęcia i pewnie się o nich nie dowiemy

Na pewnym etapie swojego obcowania z nowymi technologiami zacząłem to po prostu akceptować. Nie ucieknę przecież przed chmurami, mailami, łącznością z Internetem; nie zamknę się w lepiance bez prądu i zrezygnuję z życia w przestrzeni wirtualnej. Byłoby to dla mnie zupełnie niewykonalne. Myśląc o tym, jak duża może być skala inwigilacji użytkowników w kręgu gigantów technologicznych... uznałem że nie mogę z tym nic zrobić. Więc się tym po prostu nie przejmuję, rzecz jasna dopóki nie odbywa się to z odczuwalną dla mnie szkodą.

Jak chodzi natomiast o pedofilów, dręczycieli zwierząt, gwałcicieli, prześladowców z pobudek rasistowskich, ideologicznych - algorytmy jestem w stanie zaakceptować. Dlaczego? Chociażby dlatego, że w tak ogromnych kopalniach danych, jakimi są usługi chmurowe, media społecznościowe, inne przestrzeni masowego przesyłania / odbierania danych nie da się w prosty sposób kontrolować tego, co w nich się znajduje. Moderatorzy na Facebooku czy Twitterze nie ogarną wszystkiego, co się tam dzieje. Algorytmy wyłapujące wykolejeńców i bandytów są potrzebne. Tym bardziej, że nie jest tajemnicą to że do niedawna jeszcze w serwisie Zuckerberga prężnie działały zamknięte grupy, w których pedofile wymieniali się grafikami. Oby tylko owe mechanizmy nie były wykorzystywane w złym celu...

Hej, jesteśmy na Google News - Obserwuj to, co ważne w techu