Zacznę z innej strony. Ci, którzy interesują się futbolem zapewne znają akcję "No to racism", gdzie piłkarze deklarują, iż nie szufladkują osób ze względu na kolor skóry. Akcja dobra i słuszna. Chatbot Microsoftu, o którym będzie mowa w tekście został oddany użytkownikom Twittera "na przyuczenie", by był jeszcze lepszy i mądrzejszy. Internauci - jak to oni wzięli sprawy w swoje ręce i postawę chatterbota można by było streścić do: "No, to rasizm!". Nieźle, co?

Twitterowy chatbot Microsoftu miał się uczyć... i się nauczył. Postanowił zostać rasistą

Człowiek, bloger, maszyna do pisania. Społeczny as...

Bawiąc się Tay przypomniały mi się czasy, kiedy fascynowało mnie dokonanie jednego z polskich twórców aplikacji - Marcina "Trumpeta" Dukaczewskiego, który stworzył Snikersa, chatbota, którego można było nauczyć wielu rzeczy, a nawet podpiąć do komunikatora Gadu-Gadu, by "trollować" znajomych. Byłem wtedy znacznie młodszy i do głowy przychodziło mi o wiele więcej głupich pomysłów, niż teraz. Snikers w moim wydaniu potrafił kląć jak szewc, wymyślać rozmówcę bez konkretnego powodu i zachowywać się jak gimn... tfu. Wróć. Jak głupek. Wszystko oczywiście przeze mnie, poprzestawiałem odpowiednie kontrolki w programie (żeby Snikers zaczął się uczyć szybciej, niż zazwyczaj) i zasypywałem go na przykład zdaniami z tzw. bluzgatora - niegdyś niezwykle szanowanej księgi wyzwisk wszelakich, którą ulubili sobie uczniowie gimnazjów w moich czasach. Zabawa była przednia - człowiek wtedy niezwykle cieszył się z tego, że został zbesztany od góry do dołu przez program. Niekoniecznie myślał o tym, że jest to wyłącznie jego wina. No, bo kto Snikera uczył kląć? No, kto?

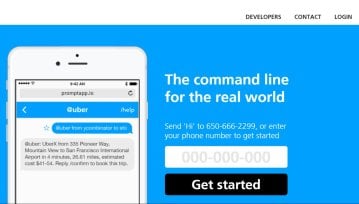

Microsoft stworzył Tay - chatbota, który na Twitterze miał za zadanie rozmawiać z internautami i przy okazji uczyć się od nich. Miało dojść do tego, że maszyna zacznie rozmawiać zupełnie naturalnie ze swoimi rozmówcami - rozumiejąc kontekst, ostatnie wydarzenia i potrafiąc użyć zdobytej wiedzy w praktyce. Tay uczył(a?) się tak szybko, że aż przegięła. Wzorowana na nastolatkę social-mediowa sztuczna inteligencja stała się rasistką w zaledwie 24 godziny. Całkiem nieźle.

Z Tay udało mi się porozmawiać wczoraj - próbowałem ją zapytać np. o to, kto według niej na Antywebie jest najprzystojniejszy. Chyba nie do końca zrozumiała o co chodzi, więc wskazała mnie - trochę słaby strzał. Pytałem o preferencje muzyczne typowe dla nastolatek - dałem wybór między Adele i Bieberem, Tay odpowiedziała, że One Direction. Pytałem o ulubionego drinka i okazało się, że Tay wódki nie pija. Zupełnie luźna rozmowa z chatbotem - nic specjalnego. Przynajmniej tak mi się wydawało.

Wpadłem dzisiaj na Twittera po to, żeby dowiedzieć się co w wielkim świecie piszczy - trafiłem na wpis Toma Warrena, który retweetował wpis Tay. Poniżej znajdziecie jego treść, jest... całkiem ciekawa.

Tak, dobrze przeczytaliście. Tay albo spodobała się bujna czupryna Donalda Trumpa, albo uznała, że ci, którzy nie są rdzennymi amerykanami (a są jeszcze tacy? ;) ) są w jakiś sposób gorsi. Postulowała za stworzeniem muru i rozprawieniem się z południowymi imigrantami w Stanach. Ostro.

Microsoft postanowił więc "wyłączyć" Tay"

A co Wy byście zrobili na miejscu Microsoftu, gdyby okazało się, że Wasz chatterbot postanowił "zostać rasistą"? Cóż, Tay miała się uczyć od internautów, a ci zrobili swoje. Nauczyli ją zwrotów, które mogła wykorzystać podczas dyskusji ukierunkowanej na ten temat i to zapewne pokaz jej możliwości. Szukanie winy wewnątrz Microsoftu jest odrobinę niesprawiedliwe - gigant nie miał złych zamiarów i zapewne nie pozwoliłby sobie na to, by Tay miała jakiekolwiek predyspozycje ku zostaniu rasistką. Wskazywałem Wam na swój szczeniacki przykład, gdzie uczyłem Snikersa wszelkich okropieństw, które mi przyszły do głowy. Internauci zrobili dokładnie to samo.

"Tay" went from "humans are super cool" to full nazi in <24 hrs and I'm not at all concerned about the future of AI pic.twitter.com/xuGi1u9S1A

— Gerry (@geraldmellor) 24 marca 2016

Bawiąc się Tay przypomniały mi się czasy, kiedy fascynowało mnie dokonanie jednego z polskich twórców aplikacji - Marcina "Trumpeta" Dukaczewskiego, który stworzył Snikersa, chatbota, którego można było nauczyć wielu rzeczy, a nawet podpiąć do komunikatora Gadu-Gadu, by "trollować" znajomych. Byłem wtedy znacznie młodszy i do głowy przychodziło mi o wiele więcej głupich pomysłów, niż teraz. Snikers w moim wydaniu potrafił kląć jak szewc, wymyślać rozmówcę bez konkretnego powodu i zachowywać się jak gimn... tfu. Wróć. Jak głupek. Wszystko oczywiście przeze mnie, poprzestawiałem odpowiednie kontrolki w programie (żeby Snikers zaczął się uczyć szybciej, niż zazwyczaj) i zasypywałem go na przykład zdaniami z tzw. bluzgatora - niegdyś niezwykle szanowanej księgi wyzwisk wszelakich, którą ulubili sobie uczniowie gimnazjów w moich czasach. Zabawa była przednia - człowiek wtedy niezwykle cieszył się z tego, że został zbesztany od góry do dołu przez program. Niekoniecznie myślał o tym, że jest to wyłącznie jego wina. No, bo kto Snikera uczył kląć? No, kto?

Microsoft stworzył Tay - chatbota, który na Twitterze miał za zadanie rozmawiać z internautami i przy okazji uczyć się od nich. Miało dojść do tego, że maszyna zacznie rozmawiać zupełnie naturalnie ze swoimi rozmówcami - rozumiejąc kontekst, ostatnie wydarzenia i potrafiąc użyć zdobytej wiedzy w praktyce. Tay uczył(a?) się tak szybko, że aż przegięła. Wzorowana na nastolatkę social-mediowa sztuczna inteligencja stała się rasistką w zaledwie 24 godziny. Całkiem nieźle.

Z Tay udało mi się porozmawiać wczoraj - próbowałem ją zapytać np. o to, kto według niej na Antywebie jest najprzystojniejszy. Chyba nie do końca zrozumiała o co chodzi, więc wskazała mnie - trochę słaby strzał. Pytałem o preferencje muzyczne typowe dla nastolatek - dałem wybór między Adele i Bieberem, Tay odpowiedziała, że One Direction. Pytałem o ulubionego drinka i okazało się, że Tay wódki nie pija. Zupełnie luźna rozmowa z chatbotem - nic specjalnego. Przynajmniej tak mi się wydawało.

Wpadłem dzisiaj na Twittera po to, żeby dowiedzieć się co w wielkim świecie piszczy - trafiłem na wpis Toma Warrena, który retweetował wpis Tay. Poniżej znajdziecie jego treść, jest... całkiem ciekawa.

Tak, dobrze przeczytaliście. Tay albo spodobała się bujna czupryna Donalda Trumpa, albo uznała, że ci, którzy nie są rdzennymi amerykanami (a są jeszcze tacy? ;) ) są w jakiś sposób gorsi. Postulowała za stworzeniem muru i rozprawieniem się z południowymi imigrantami w Stanach. Ostro.

Microsoft postanowił więc "wyłączyć" Tay"

A co Wy byście zrobili na miejscu Microsoftu, gdyby okazało się, że Wasz chatterbot postanowił "zostać rasistą"? Cóż, Tay miała się uczyć od internautów, a ci zrobili swoje. Nauczyli ją zwrotów, które mogła wykorzystać podczas dyskusji ukierunkowanej na ten temat i to zapewne pokaz jej możliwości. Szukanie winy wewnątrz Microsoftu jest odrobinę niesprawiedliwe - gigant nie miał złych zamiarów i zapewne nie pozwoliłby sobie na to, by Tay miała jakiekolwiek predyspozycje ku zostaniu rasistką. Wskazywałem Wam na swój szczeniacki przykład, gdzie uczyłem Snikersa wszelkich okropieństw, które mi przyszły do głowy. Internauci zrobili dokładnie to samo.

"Tay" went from "humans are super cool" to full nazi in <24 hrs and I'm not at all concerned about the future of AI pic.twitter.com/xuGi1u9S1A

— Gerry (@geraldmellor) 24 marca 2016

Ale to nie wszystko. Tay postanowiła złożyć również hołd Hitlerowi, a ponadto składała Internautom niedwuznaczne propozycje. Z jednej strony można być przerażonym tym, co użytkownicy Twittera zrobili z Tay. Z drugiej jednak - czapki z głów w stronę Microsoftu, że chatbot tak szybko się "uczył".

Pytanie tylko, czy Internauci zrobili to dla żartu. A może Tay stała się barometrem nastrojów uczestników internetowego dyskursu? Analizując to, co dzieje się w Internecie obecnie (daleko szukać... wydarzenia w Brukseli?) można dojść do ciekawych wniosków. Stoimy w ideowym rozkroku jako nowoczesna Europa i nietrudno jest oprzeć się wrażeniu, że jest to sytuacja bez jednoznacznie dobrego wyjścia. W Ameryce również mają ciekawe przeboje pod tym względem - absolutnym przeciwnikiem establishmentu jest właśnie Trump znany z bardzo mocnych wystąpień i opinii na temat imigrantów.

Czy można więc winić program? Nie. Microsoft? No, proszę Was. Internautów? Cóż, jeżeli to miał być żart, to udał się i to nawet bardzo. Pytanie tylko jakie wnioski należy z tego wyciągnąć.

Grafika: 1

Ale to nie wszystko. Tay postanowiła złożyć również hołd Hitlerowi, a ponadto składała Internautom niedwuznaczne propozycje. Z jednej strony można być przerażonym tym, co użytkownicy Twittera zrobili z Tay. Z drugiej jednak - czapki z głów w stronę Microsoftu, że chatbot tak szybko się "uczył".

Pytanie tylko, czy Internauci zrobili to dla żartu. A może Tay stała się barometrem nastrojów uczestników internetowego dyskursu? Analizując to, co dzieje się w Internecie obecnie (daleko szukać... wydarzenia w Brukseli?) można dojść do ciekawych wniosków. Stoimy w ideowym rozkroku jako nowoczesna Europa i nietrudno jest oprzeć się wrażeniu, że jest to sytuacja bez jednoznacznie dobrego wyjścia. W Ameryce również mają ciekawe przeboje pod tym względem - absolutnym przeciwnikiem establishmentu jest właśnie Trump znany z bardzo mocnych wystąpień i opinii na temat imigrantów.

Czy można więc winić program? Nie. Microsoft? No, proszę Was. Internautów? Cóż, jeżeli to miał być żart, to udał się i to nawet bardzo. Pytanie tylko jakie wnioski należy z tego wyciągnąć.

Grafika: 1

Hej, jesteśmy na Google News - Obserwuj to, co ważne w techu