Sztuczna inteligencja i jej rozwój jest jednym z najbardziej chodliwych tematów ostatnich lat. Co rusz słyszymy o kolejnym kroku milowym, dziś na własne oczy widziałem, jak projekt DeepSense.ai radzi sobie z nauką. I jest to naprawdę imponujące!

SI obserwuje, uczy się grać i wygrywać — widziałem to na własne oczy

Miałem dziś przyjemność uczestniczyć w spotkaniu, w którym ekipa DeepSense.ai i Intela pochwaliła się swoim projektem. Projektem niebanalnym, związanym ze sztuczną inteligencją i tym, jak takowa zaczyna obserwować i uczyć się na własnych błędach.

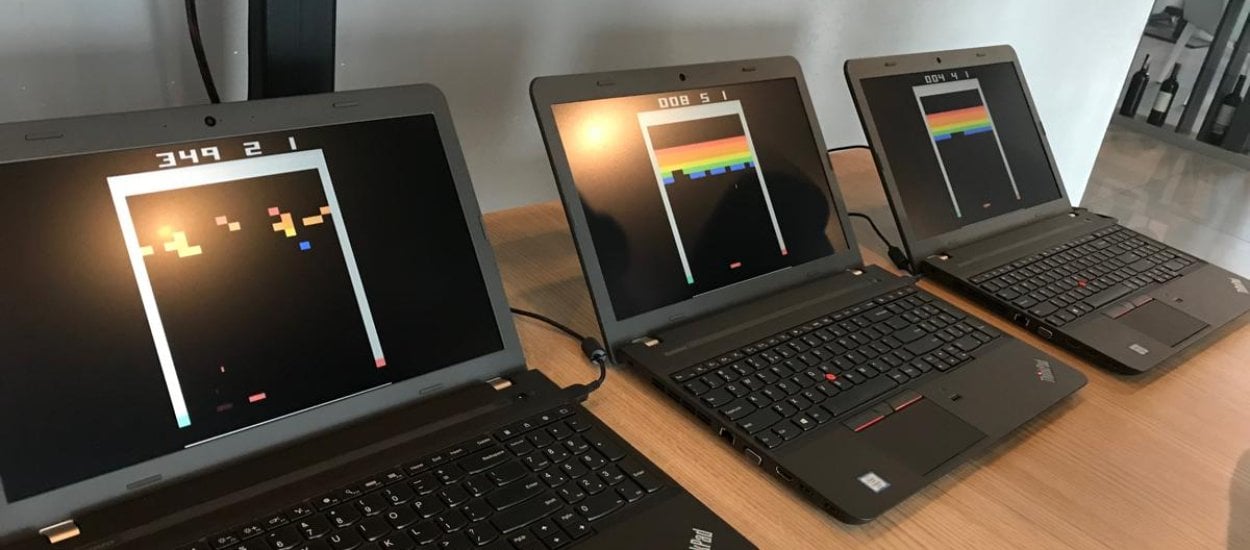

Eksperyment który obserwowaliśmy oparty był o jedną z prostych gier, które wielu z was może kojarzyć ze starych sprzętów Atari — Boxing. Sztuczna inteligencja odważyła się stawić czoła "komputerowi", czyli znanemu od lat przeciwnikowi, który trafił do oryginalnej gry w 1980 roku. Pierwsze pojedynki w wykonaniu SI wypadały dość marnie. Zawodnik sterowany przez AI solidnie obrywał, jednocześnie obserwując rozwój sytuacji i wyciągając wnioski. My zaś na specjalnych wykresach śledziliśmy jego progres, przy okazji podglądając jak ma się sytuacja ma tablicy wyników.

Po kwadransie sytuacja wyglądała o wiele lepiej, a pół godziny po starcie nauki tracił on niewiele punktów. Zdarzyły się nawet pojedynki, w których nie został uderzony ani razu. Nie da się ukryć, że całość robiła wrażenie — chociaż jak opowiedzieli nam twórcy z DeepSense.ai wspierani przez ekipę Intela — cały projekt jest naprawdę skomplikowany i świetne wyniki w tym przypadku wcale nie oznaczają sukcesu w każdej produkcji. Póki co skupili się oni na prostych (w kontekście rozgrywki) tytułach, ale sam proces nauki nie jest czymś, co będziemy mogli obserwować na co dzień. A przynajmniej jeszcze nie. Jak sami jednak przyznają — gry wideo okazują się fantastycznym medium, na którym można łatwo zobrazować i pokazać, jak to właściwie działa i w jakim tempie sztuczna inteligencja potrafi przyswajać informacje i uczyć się na własnych błędach. W tym wszystkim jest jednak pewien haczyk, na który cały czas uczulali tamtejszych gości: potrzeba superkomputera.

Ta nauka wymaga ogromnej mocy

Pewnie część z was słyszała już o tym, że mistrz świata w GO przegrał ze sztuczną inteligencją, zaś najlepsi tego świata nie dali sobie rady z NaVi w DOTA2. Potężne algorytmy rozłożyły ich na łopatki, jest jednak pewna rzecz, o której raczej się nie wspomina. Aby takowa mogła wyuczyć się wszystkich sztuczek, potrzebna były nie tylko długie godziny pracy jej ojców, ale także niezwykle wydajne maszyny, które pomagają jej w treningach. Tych wspomnianych 30 minut na naukę gry w Boxing również nie jest zasługą żadnego komputera który organizatorzy spotkania wzięli ze sobą, wszystko działo się w tle na najpotężniejszym polskim komputerze — Prometheuszu.

Sztuczna inteligencja zaczyna się uczyć, ale na realia z filmów sci-fi jeszcze poczekamy

Projekt który miałem dziś szansę zobaczyć na własne oczy zrobił na mnie ogromne wrażenie. Jednak już w przypadku prostych gier sprzed lat taka operacja jest ogromnym przedsięwzięciem — dlatego autonomiczne samochody i spółka mają naprawdę grube tomiszcza treści do nauczenia, nim będą mogły wyjechać na ulicę. Do świata zbliża się kolejna rewolucja, ale sam jestem ciekawy, kiedy twórcy gier podchwycą temat i w nich będziemy mogli zmagać się ze sztuczną inteligencją. Wyobrażacie sobie te pełne emocji gry w FIFA czy kolejne bijatyki, które będą pojawiać się na rynku?

Hej, jesteśmy na Google News - Obserwuj to, co ważne w techu